こんにちは。センスタイムジャパンの佐久間です。第23回 画像の認識・理解シンポジウム(MIRU2020)で発表した研究『ステレオマッチングのための教師なしドメイン適応』が『MIRU優秀賞』を受賞したので、その紹介をしたいと思います。

はじめに

本論文では、DNNに基づいたステレオマッチングにおいて、学習時と異なるテスト環境では視差推定精度が悪化するという問題に対して解決手法を提案しました。具体的には、CG画像をテスト環境画像に類似するようにスタイル変換し、その変換画像を使って視差推定器を学習することで、テスト環境での視差推定精度を改善するというものです。

ステレオマッチング

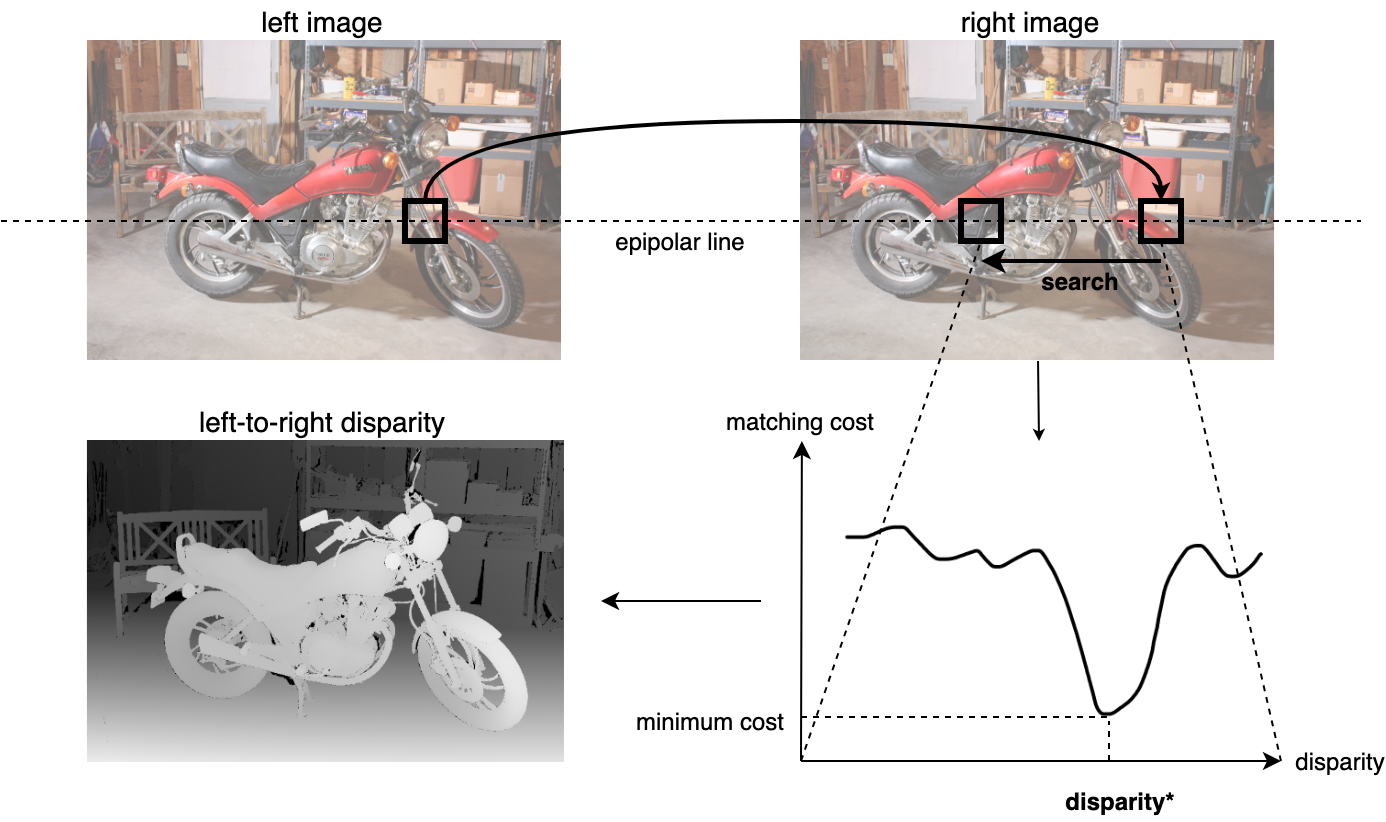

まずステレオマッチングとは何か?という説明を簡単にしたいと思います。ステレオマッチングはキャリブレーション済みの2台のカメラから取得した画像間で対応点のマッチングを求める問題です。対応点がわかれば三角測量により、3次元情報が復元できます。対応点はエピポーラ線上にあるので、平行化(rectification)という幾何学的変換により事前にエピポーラ線を水平にしておくと、探索効率を上げることができます。対応点間の$x$座標の差は視差と呼ばれ、ステレオカメラのベースライン長を$b$、焦点距離を$f$とすると、深度$z$は視差$d$から$$z=\cfrac{b \cdot f}{d}$$の関係により求めることができます。

ステレオ画像変換

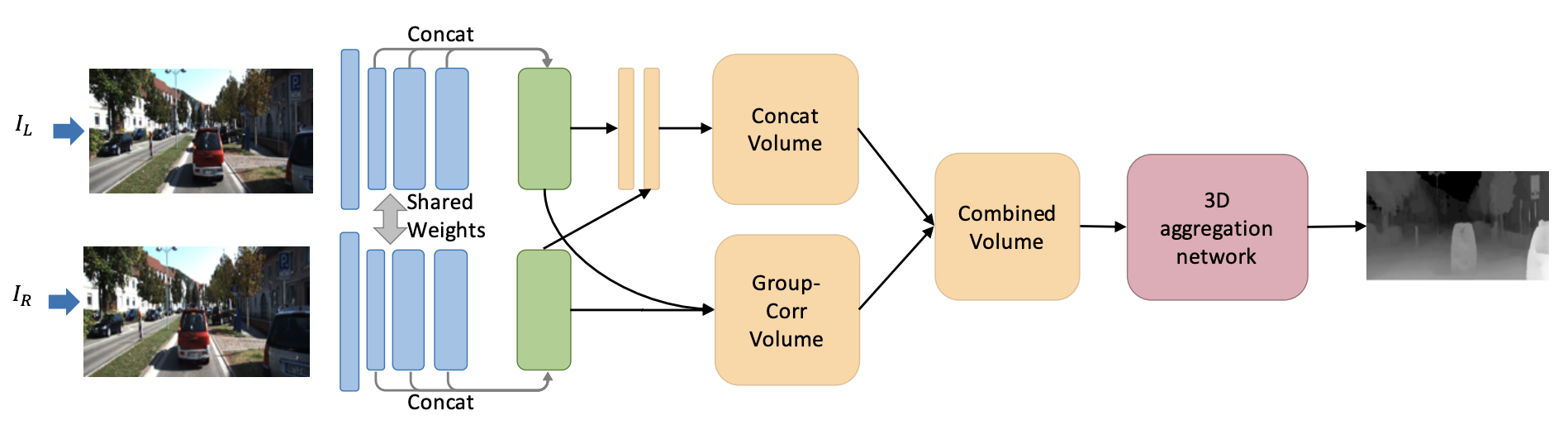

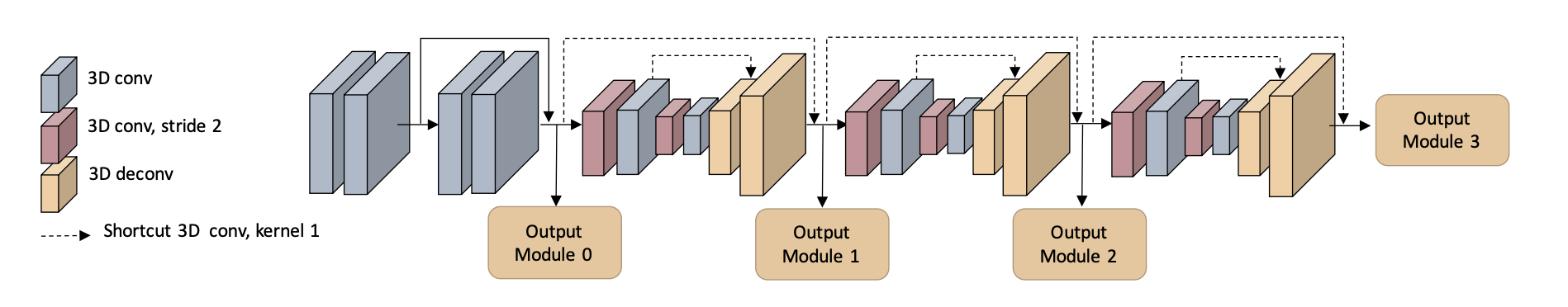

近年は他の多くのタスク同様に既存のアルゴリズムをDNNで置き換えることで様々なベンチマークで精度の向上が見られます。最近のアーキテクチャは下図のように画像に視差の次元を加えた4次元コストボリュームを3D convolutionで処理するものがポピュラーです。ここでDNNに基づいたステレオではテスト環境の教師データを多く必要とするので、テスト環境の教師データが用意できない場合は精度が悪化してしまいます。これは問題というよりはDNNに限らない全ての探索アルゴリズムの持つ性質のようなものです。

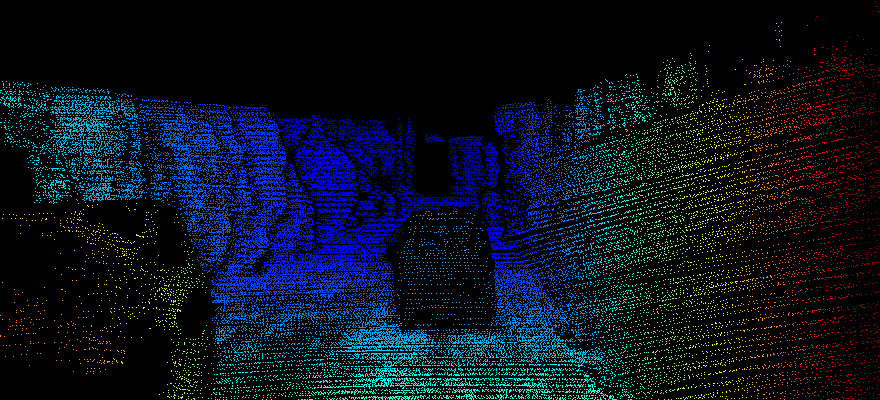

ここでステレオマッチングにおける教師データは視差であり、LiDARなどのレーザーセンサーを用いてテスト環境のデータを収集しなくてはなりません。レーザーセンサーの価格や、レーザーセンサーとカメラ間のキャリブレーションなどを考えるとコストが高いです。

ステレオ画像は簡単に収集できるので、ステレオ画像のみを用いてモデルの精度を向上させることができると嬉しいです。本研究では、CG画像をテスト環境画像に類似するようにスタイル変換し、その変換画像と変換前のCG画像の視差ラベルを使ってモデルを学習することで、テスト環境の教師データを用いずに、モデルの精度を向上させることを考えます。

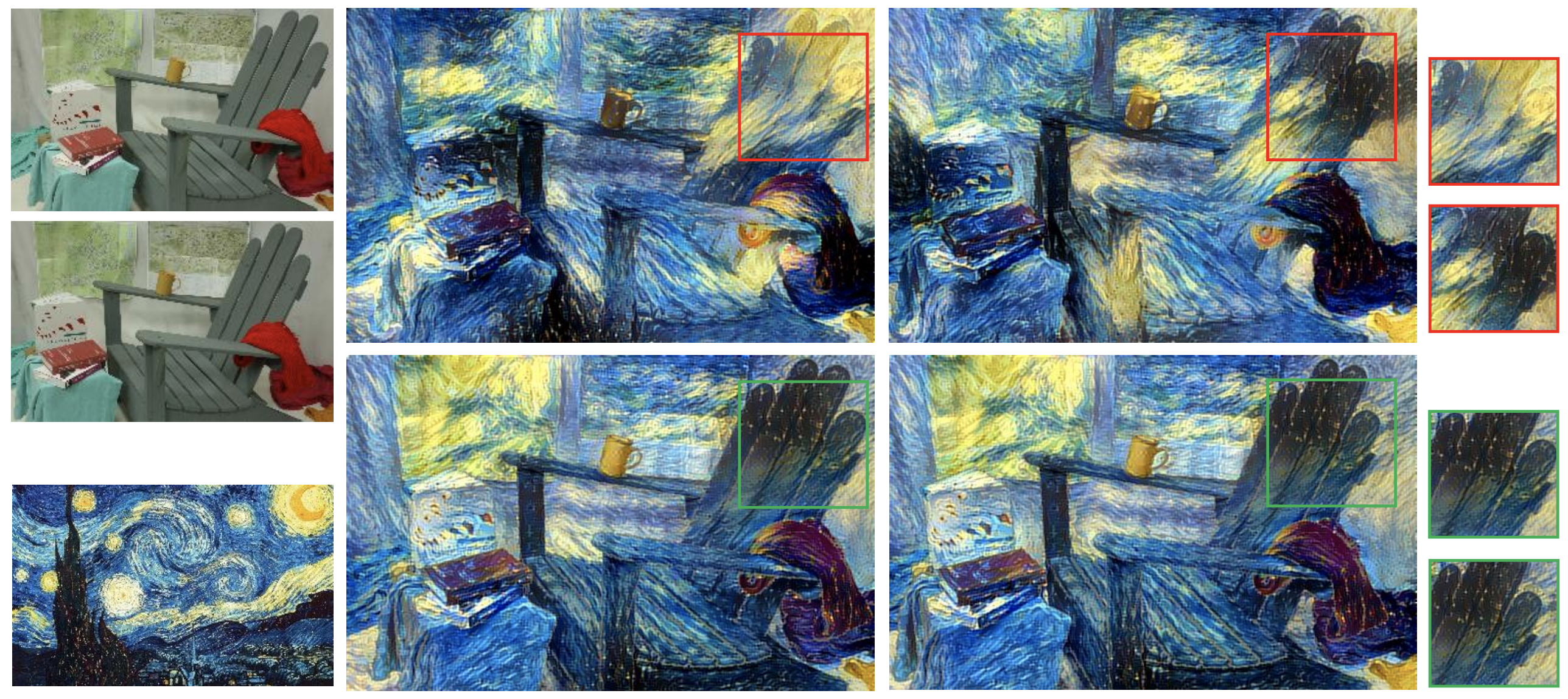

このような画像変換に基づくドメイン適応手法は、コンピュータビジョンの様々なタスクで用いられていますが、ステレオマッチングにそのまま適用させることは難しいという問題がありました。以下の図ではステレオペアの各ビューを独立して画像変換すると、本来同じ見た目であるはずの赤枠の対応領域の見た目が異なってしまう様子が確認できます。

これは変換前のCG画像の視差ラベルとの不一致を意味し、このような画像は教師あり学習に悪影響を及ぼします。

提案手法

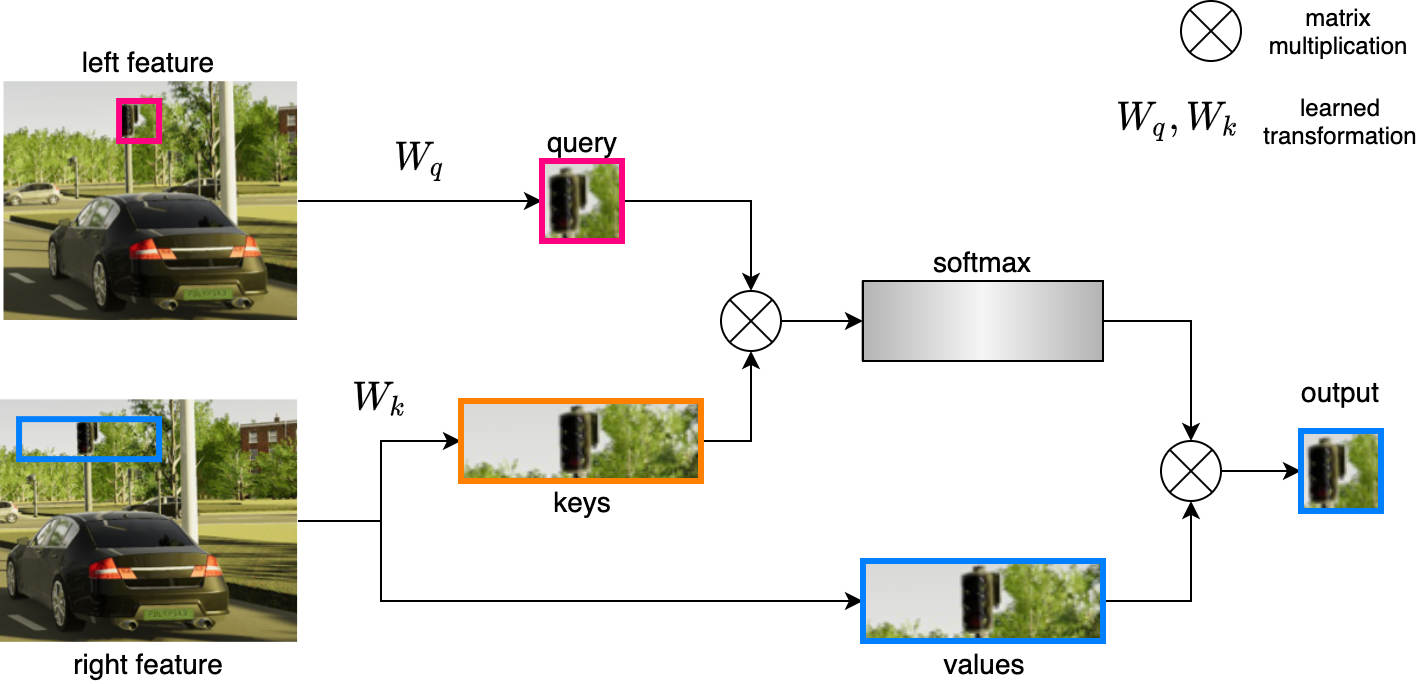

本研究ではAttention [3]を用いて左右のビュー間で特徴の共有をすることで、画像変換後の左右ビュー間のステレオ整合性を保つ手法を提案しました。AttentionはSelf-Attention [4]をベースとして、注意を向ける先を他方のビューのエピポーラ線に制限しました。これにより対応点の特徴をAttentionによって取り込むことを目指します。Attentionがビュー間でクロスするという意味で論文ではStereoscopic Cross-Attention (SCA) と呼んでいます。

SCAを画像変換のためのGANに組み込むことによりCG画像をテスト環境画像に、そのステレオ整合性を保ったままスタイル変換することが可能です。

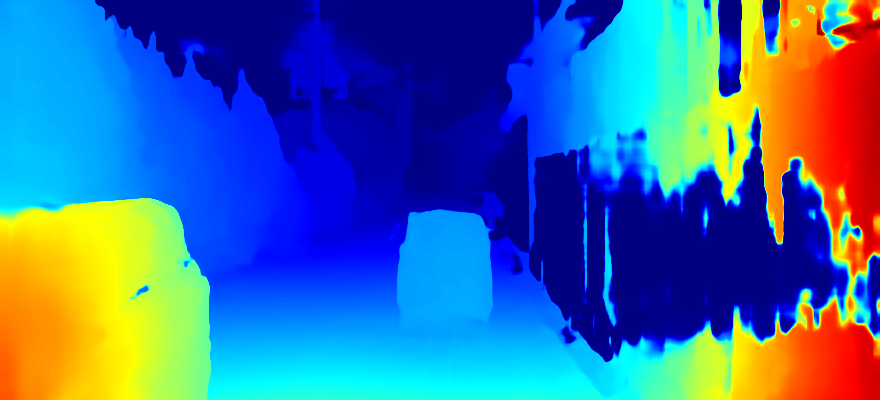

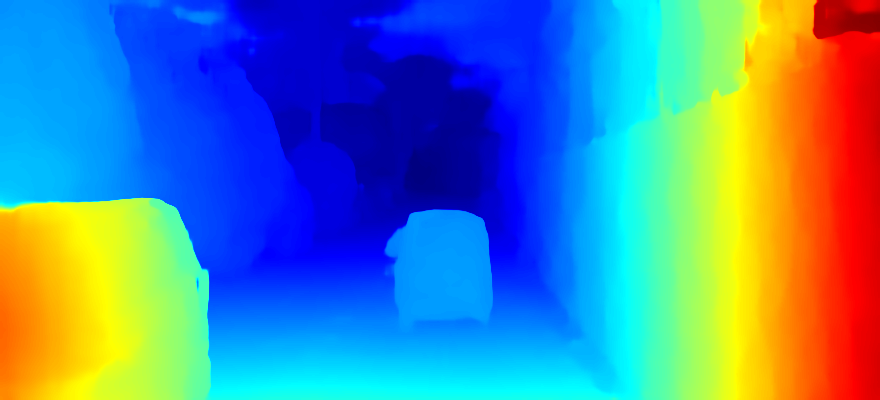

以下の図では変換画像と変換前のCG画像の視差ラベルを使ってモデルを学習することで、ドメイン適応前では推定できていなかった壁面の視差が、ドメイン適応により適切に推定できるようになったことが確認できます。

実際には、画像変換のためのGAN損失、CGラベルとの教師あり損失に加えて、単眼深度推定でよく用いられる自己教師あり損失やSCAをガイドするための損失を設計し、全てを同時に最小化しています。モデルの詳細や、他の手法との定量的な評価などは近日中に公開予定のarXiv論文をご覧ください。

参考文献

[1] X. Guo, K. Yang, W. Yang, X. Wang, and H. Li, "Group-wise correlation stereo network," Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019.

[2] D. Chen, L. Yuan, J. Liao, N. Yu, and G. Hua, “Stereoscopic neural style transfer,” in Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018.

[3] D. Bahdanau, K. Cho, and Y. Bengio, “Neural machine translation by jointly learning to align and translate,” in International Conference on Learning Representations, 2015.

[4] A. Vaswani, N. Shazeer, N. Parmar, J. Uszkoreit, L. Jones, A. N. Gomez, Ł. Kaiser, and I. Polosukhin, “Attention is all you need,” in Advances in Neural Information Processing Systems, 2017.

[5] Y. Cabon, N. Murray, and M. Humenberger, "Virtual kitti 2," arXiv preprint arXiv:2001.10773, 2020.

[6] G. Yang, X. Song, C. Huang, Z. Deng, J. Shi, and B. Zhou, "Drivingstereo: A large-scale dataset for stereo matching in autonomous driving scenarios," Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019.

投稿者プロフィール

-

研究開発センター 研究チーム所属 リサーチャー。博士(理学)。

趣味は主に科学関係の読書。

最新の投稿

- 2022.06.01STJ統計検定1級受験記

- 2021.12.17STJRendering 3D Fractals by Sphere Tracing

- 2021.12.13STJエッジAIコンピューティングについて

- 2021.10.06STJセンスタイムによるCVPR2020発表論文: DNN枝刈り(Pruning)手法 「DMCP」を紹介します